因发热和互联故障,英伟达GB200再延期,遭客户砍单

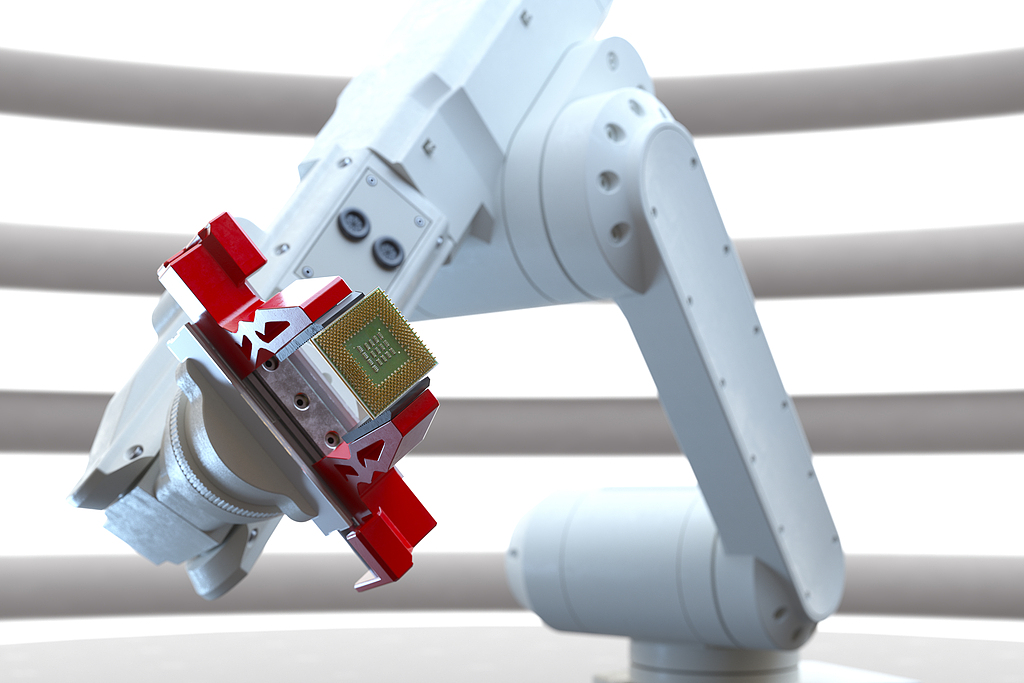

据报道,GPU制造商英伟达再次推迟其数据中心AI芯片GB200的交付时间。此次交付延迟的主要原因是过热问题和芯片互联故障。

英伟达第一批搭载Blackwell芯片的机架在运行时出现过热现象,影响了芯片性能和机架其他部件。并且,Blackwell芯片之间的互联出现了问题,在高性能计算领域,芯片之间的高效互联是确保系统整体性能的关键。一旦互联出现问题,将严重影响数据的传输速度和系统的稳定性。

由于交付延迟,英伟达主要客户微软、亚马逊云部门、Alphabet 旗下谷歌和 Meta Platforms被曝已经削减了英伟达Blackwell GB200机架的部分订单,这些客户每家都下了价值100亿美元或更多的 Blackwell 机架订单。此前英伟达首席执行官黄仁勋曾表示,该公司有望在第四财季通过Blackwell芯片增加数十亿美元的收入。

据参与微软和OpenAI数据中心建设的内部人士透露, 微软原本打算在其位于凤凰城的数据中心安装配备至少5万颗Blackwell芯片的GB200机架,以满足OpenAI的运算需求。但目前OpenAI已经开始要求微软提前交付上一代的英伟达H200芯片。这就意味着,原本计划大规模部署GB200机架的凤凰城数据中心,目前改为部署H200芯片。

知名分析师郭明錤表示:“GB200 NVL72的量产计划从9月推迟到2024年12月,目前将又从今年第一季度推迟到第二季度。今年的出货量将减少一半,从58000个机架减少到25000个。”

根据公开资料显示,一个GB200包含一颗Grace 72核的ARM CPU和2颗Blackwell GPU,对应的功耗为 2700W。芯片之间采用台积电的CoSoW 3D堆叠封装封装技术,先把2颗Blackwell GPU通过RDL再布线层缝合在一起,然后再与Grace 72核的ARM CPU和其它元器件封装在整个硅晶圆上。

2024年11月,有报道称Blackwell芯片由于高负荷运算产生的热量超出了现有散热系统的处理能力,出现了服务器机架过热现象。针对此,英伟达多次要求供应商调整机架设计以缓解这一问题,但目前尚未找到有效的解决方案,同时为了解决该问题,英伟达正在与多家云服务提供商合作,共同优化散热方案。

据悉,为了改善Blackwell芯片的散热系统,英伟达已经对服务器机架设计进行了多项修改。英伟达还向Open Compute Project(OCP)贡献了NVIDIA GB200 NVL72机架和计算以及交换机托盘的液冷设计。这种液冷设计使得系统能够更有效地管理热量,从而提高整体系统的稳定性和可靠性。

当时,黄仁勋在业绩发布会上表示,散热问题已经解决,Blackwell服务器的供应不会中断。但如今,证明Blackwell GB200服务器机架发热问题尚未完全解决。此前,英伟达在GTC大会上也晒出了关于GB200的样机,采用的液冷散热架构,其液冷机架方案是由鸿海的子公司鸿佰提供。

芯片之间的互联故障也是导致交付延迟的另一个重要原因。在此之前,GB200就曾出现过互联失效现象,据英伟达自己的解释,是因为再布线层的各个引组间的电阻不相同,在高速数据传输与校验时,芯片出现互联信号失真现象,导致GB200不能正常工作。当时英伟达与台积电都表示,会通过修改RDL的再布线层与周边元器件的设计,来完善两颗芯片间的数据联接,让整个系统可以高效运行。

英伟达AI芯片在3D堆叠封装中存在两大难点,一是RDL与各个主控芯片间的联连可靠性、电性能平衡处理、信号互联处理等难题,二是TSV硅穿孔联接的高速HMB内存模块与硅基板之间的混和键合稳定性难题,主控芯片与硅基板之间的金属层键合难题。

英伟达GB200首次应用了通过RDL中间层来把两颗Blackwell GPU缝合在一起的工艺,因此出现互联故障,不排除是因为引入该工艺造成了整个3D堆叠互连技术的工艺差异性被放大,从而让里面的各个小CHIP芯片之间的信号传输数据,得不到有效的验证与放行,从而出现整个GB200系统互联失效。

目前,使用玻璃基板来代替现有RDL的呼声很高,并且认为玻璃基板可以解决热管理失效导致的互联失效难题问题。再加上台积电和英伟达都曾表示将会在未来支持玻璃基板封装技术,因此,有业内人士认为如果现有工艺无法解决GB200热管理失效与互联失效难题,英伟达可能会尝试使用玻璃基板来解决。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。